Deep Joint Entity Disambiguation with Local Neural Attention

Octavian-Eugen Ganea and Thomas Hofmann

Proceedings ofthe 2017 Conference on Empirical Methods in Natural Language Processing, pages 2619–2629 Copenhagen, Denmark, September 7–11, 2017.

https://www.aclweb.org/anthology/D17-1277

どんなもの?

文書レベルでのエンティティの曖昧性解消(entity disambiguation)のためのDeepLearningモデルを提案

DeepLearningの利点とgraphical models や probabilistic mention-entity mapsなどの伝統的なアプローチを組み合わせたもの

先行研究と比べてどこがすごい?

従来のEntity disambiguation(ED)システムは大部分が手動で設計されたfeaturesを使っている。

それらの基本的なfeaturesをディープラーニングを使うことでゼロから学ぶことで、広範なコーパスに頼る必要がない。

このようなアプローチは当時では初めてのアプローチ

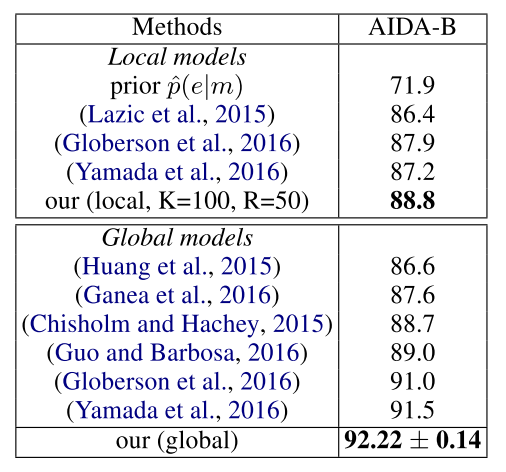

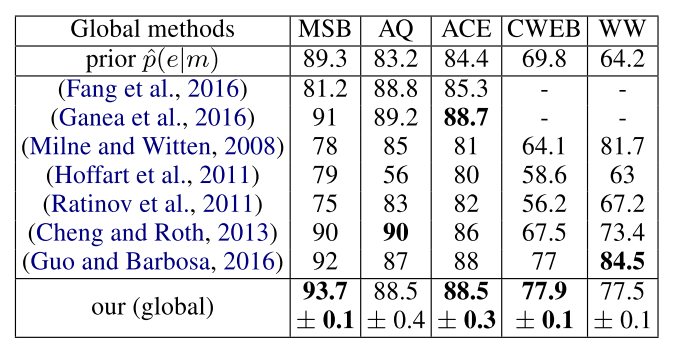

そこそこのコストでSOTA(当時)やそれと同程度のaccuracyを達成

技術や手法のキモはどこ?

entity embedding、contextual attention mechanism、adaptive local score combination、unrolled differentiable message passing for global inferenceを組み合わせたEDのためのDeepLearning Architectureを提案

どうやって有効だと検証した?

議論はある?

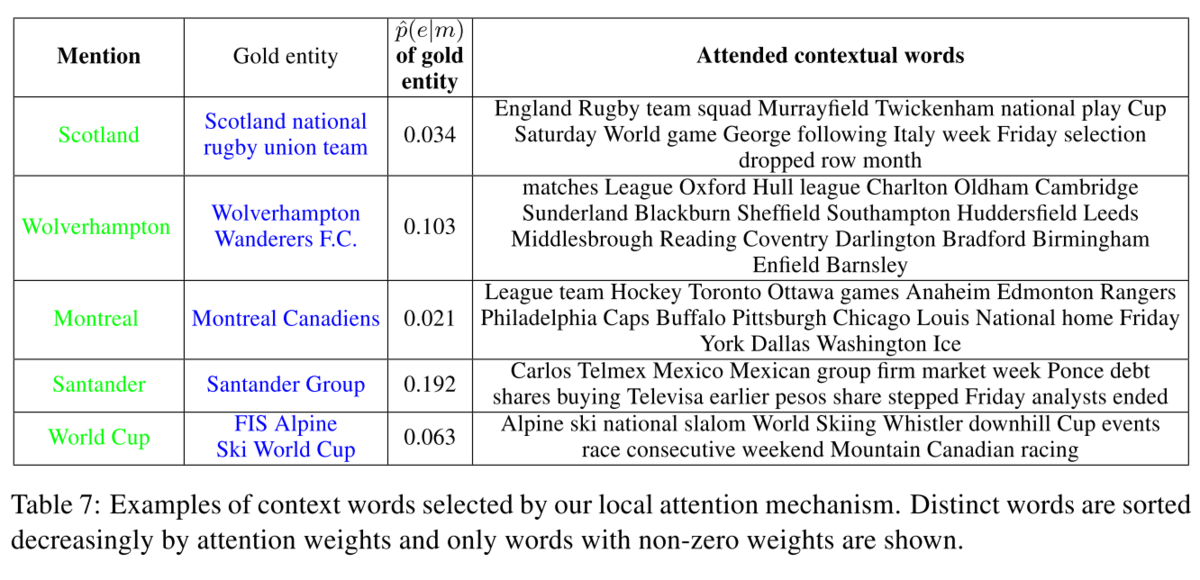

エラー分析:

(1)アノテーションエラー

(2)候補となるエンティティの集合に現れないgold entity

(3)p(e|m)が非常に低いgold entityで、優先度の高い誤ったエンティティ候補を持つ言及

(3)の例として、「Italian」という言及は国を意味するエンティティではなく、「イタリア代表フットボールチーム」を指す。

文脈情報はこのような間違いを回避するのに十分ではない。

次に読むべき論文は?

Ikuya Yamada, Hiroyuki Shindo, Hideaki Takeda, and Yoshiyasu Takefuji. 2016. Joint learning of the embedding of words and entities for named entity disambiguation. CoNLL 2016, page 250.